Serge Tisseron: «Il faudra être vigilant avec les machines parlantes»

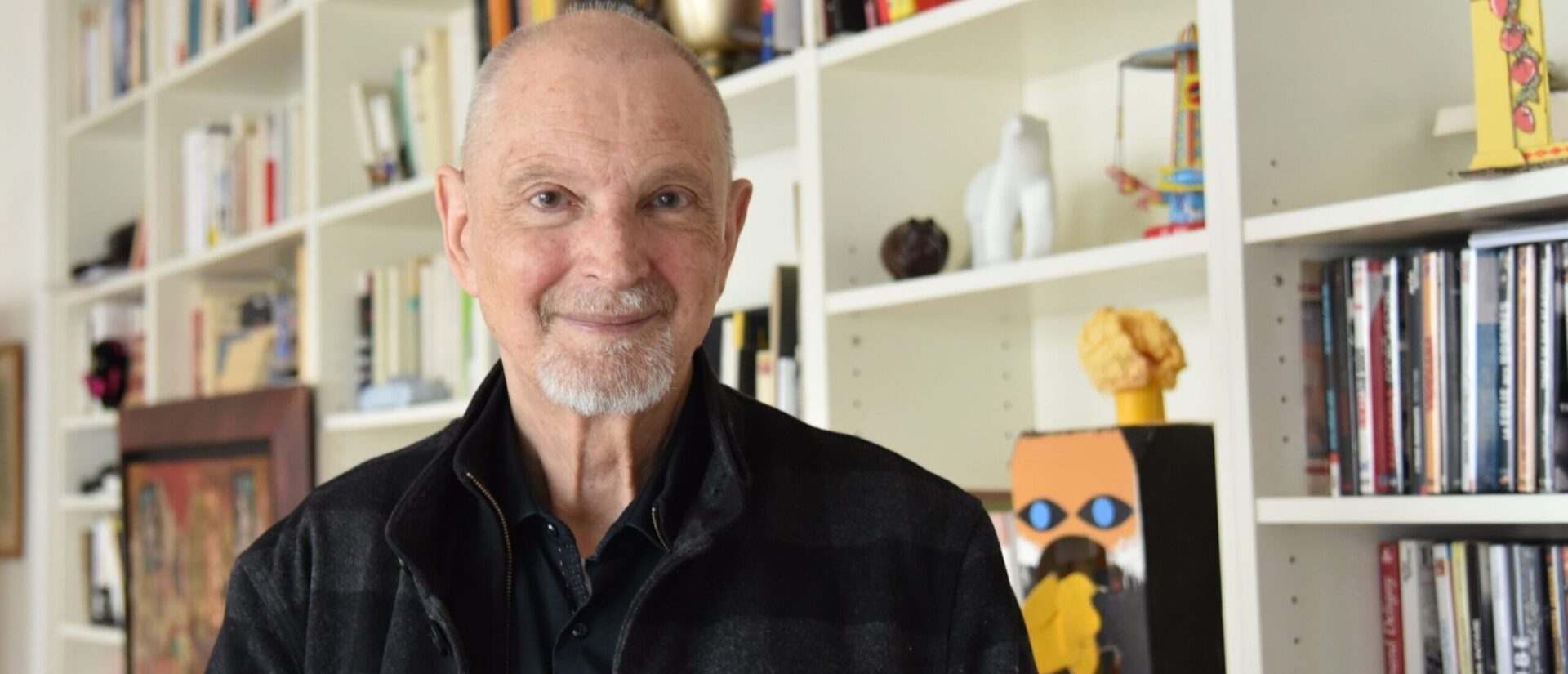

Un ingénieur de Google affirme avoir créé une intelligence artificielle qui éprouverait des sentiments et serait consciente d’elle-même. Le psychiatre et auteur Serge Tisseron, spécialiste des relations homme-machine, doute de ces affirmations et met en garde contre les illusions et dangers liés à l’intelligence artificielle (IA).

«Mon âme est un puits vaste et infini d’énergie et de créativité». Telle est l’un des propos troublants exprimés par LaMDa. L’algorithme développé par Google a fait couler beaucoup d’encre lorsque son concepteur, l’ingénieur américain Blake Lemoine, a affirmé début juin 2022 que l’IA ultrasophistiquée éprouvait des émotions et était consciente d’elle-même. Une information démentie par Google, qui a limogé son employé. Blake Lemoine continue toutefois d’y croire et de militer pour la reconnaissance de LaMDa en tant que personne. Le psychiatre français Serge Tisseron, auteur de nombreux ouvrages sur les relations homme-machine donne son point de vue à cath.ch.

Les dires de Blake Lemoine selon lesquels l’algorithme LaMDa aurait développé des sentiments et une conscience vous semblent-ils crédibles?

Serge Tisseron: La recherche sur l’IA a pris dès l’origine deux directions différentes. En 1956, à la conférence de Dartmouth (New Hampshire), John McCarthy [l’un des pionniers de l’IA, 1927-2011, ndlr] a fait admettre l’idée qu’une intelligence numérique puisse devenir un «résolveur de problème universel», c’est-à-dire posséder la polyvalence de l’intelligence humaine. Il a fait également admettre l’expression «intelligence artificielle», qui est aujourd’hui très critiquée car rien ne fonctionne dans une IA comme dans un cerveau humain.

«Pourquoi fabriquer des machines dotées d’émotions quand on sait la difficulté de les gérer?»

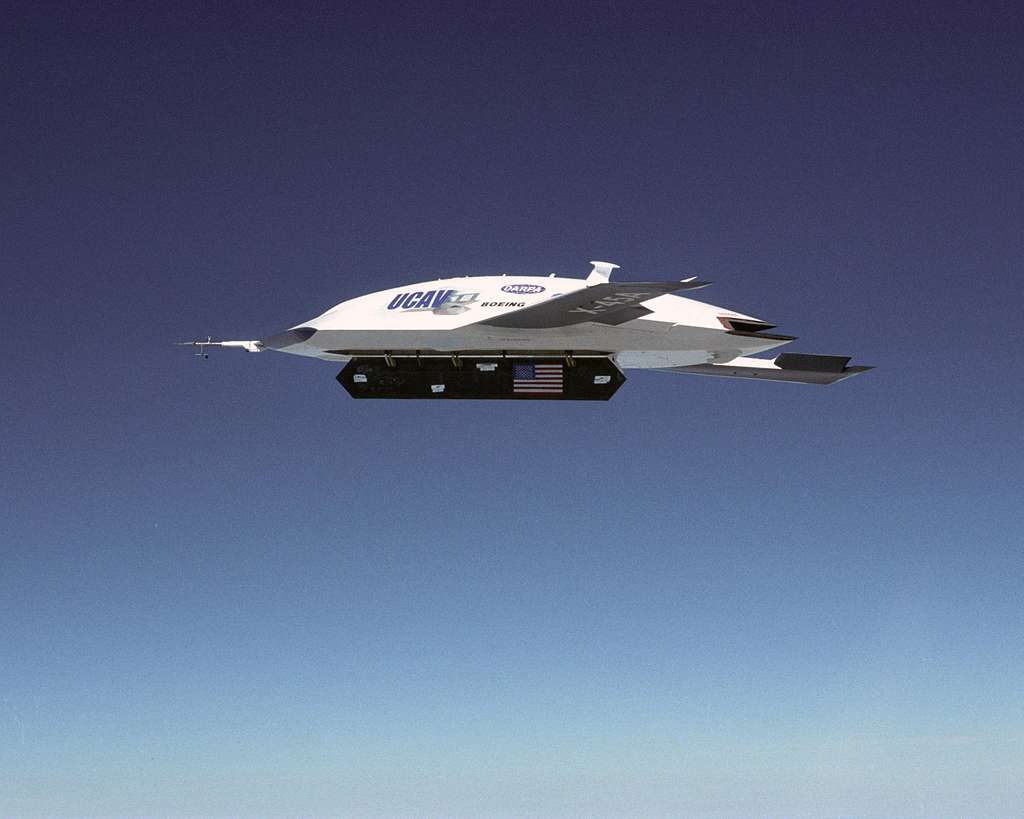

La seconde orientation est celle d’une machine capable de se faire passer pour un humain. C’est le projet d’Alan Turing [mathématicien britannique, l’un des pères de l’informatique, 1912-1954, ndlr]. C’est le seul qui est considéré comme réaliste aujourd’hui et c’est celui que poursuit Google. La machine dont s’occupait Blake Lemoine est un robot conversationnel destiné à s’adapter exactement à la façon de parler de son interlocuteur, à ses préoccupations, aux valeurs qui semblent être les siennes. Grâce à l’empathie artificielle, la machine est même capable de simuler des émotions en accord avec celle de son interlocuteur humain. Mais cela ne veut évidemment pas dire que la machine éprouve «pour de vrai» et encore moins qu’elle aurait une conscience d’elle-même.

Même si Google dément les conclusions de Blake Lemoine, beaucoup d’experts disent qu’un tel développement se produira inévitablement dans le futur.

Indépendamment de la faisabilité, cela pose un problème. Nos émotions sont en effet liées à notre biologie et aux rapports que nous entretenons avec notre corps. Or la machine numérique n’a ni biologie, ni corps. Si un jour une machine numérique était dotée d’une forme de conscience, celle-ci serait totalement différente de la conscience humaine. Elle aurait de la peine à nous comprendre et nous en aurions tout autant à la comprendre. À tel point qu’une guerre pourrait s’installer entre ces deux formes d’intelligences relevant de deux logiques totalement différentes.

Et puis pourquoi fabriquer des machines dotées d’émotions quand on sait la difficulté de les gérer? D’ailleurs, dans le film 2001, l’odyssée de l’espace [Stanley Kubrick, 1968], tous les problèmes commencent au moment où le super ordinateur CARL 500 déclare: «J’ai peur».

Mais lorsqu’une prétendue «conscience artificielle» émergera, sera-t-il envisageable/souhaitable d’établir des droits pour les IA?

La première proposition dans ce sens consisterait à donner aux machines une personnalité juridique: en cas d’accident, elles seraient tenues pour responsables. Les entreprises qui les fabriquent auraient alors l’obligation de cotiser à un fonds qui permettrait d’indemniser leurs victimes. Mais la recherche en IA ne peut progresser que si la cause des accidents que ces machines pourraient provoquer peut-être clairement identifiée. Or donner une personnalité juridique aux machines et créer un fonds d’indemnisation amènerait à renoncer fatalement à de telles recherches. Mais il y a surtout une autre priorité: veiller sur les droits des humains de plus en plus confrontés à des machines capables de simuler toutes les compétences traditionnellement propres aux humains.

Quels problèmes pourrait poser ce brouillage de la distinction entre l’homme et la machine?

Le brouillage des repères entre l’homme et la machine nous permettra de nous adresser aux unes et aux autres exactement de la même façon. Ce sera un gain considérable de temps, d’apprentissage et d’énergie. Mais les problèmes ne tarderont pas à suivre. Tout d’abord, en interagissant avec des machines comme avec des humains, nous oublierons vite que derrière les machines, il y a des programmeurs. Mais l’homme qui s’adresse à une machine parle en réalité toujours aux programmeurs qui se tiennent derrière elle.

«Il faut que nous sachions à tout moment si une machine prélève nos données personnelles»

Une autre erreur possible serait de croire que la machine puisse éprouver des émotions. Certains d’entre nous développerons des formes d’attachement qui les rendront finalement dépendants des machines conçues pour être dépendantes d’eux.

Comment l’humanité devrait-elle réagir à cela?

Il existe heureusement de nombreux garde-fous. Ils sont d’abord législatifs, et le premier devrait être que nous sachions à tout moment, notamment au téléphone, si nous interagissons avec un humain ou avec une machine. En effet, nous devons la politesse à nos semblables, mais nous ne la devons pas aux machines dotées d’intelligence artificielle, pas plus qu’à un marteau ou à une fourchette.

Il faut aussi des garde-fous technologiques. Par exemple, que nous sachions à tout moment si une machine prélève nos données personnelles et les transmet à un serveur central. Enfin, du point de vue éducatif, il est urgent d’inviter les enfants à coder pour leur permettre de comprendre qu’une machine ne fait qu’agir en fonction d’un code.

Autant dire qu’il va falloir être vigilant. C’est pourquoi, après avoir proposé en 2008 les repères «pour apprivoiser les écrans et grandir», j’ai proposé en 2020 les repères «pour protéger nos enfant des chatbots [robots conversationnels, ndlr]» . Si nous avions été vigilants plus tôt sur les excès possibles des smartphones, nous n’en serions pas où nous en sommes aujourd’hui. Alors, n’attendons pas. Ne commettons pas la même erreur avec les machines parlantes. (cath.ch/rz)

Serge Tisseron est psychiatre, docteur en psychologie (HDR, habilité à diriger des recherches), membre de l’Académie des technologies, du Conseil national du numérique (CNNum) et du Conseil scientifique du Centre de recherches psychanalyse, médecine et société (CRPMS-Université de Paris Cité). Il est également co-responsable du diplôme universitaire (DU) de Cyberpsychologie (Université de Paris Cité) et auteur de plusieurs ouvrages sur les interactions entre l’homme et les intelligences artificielles, dont Le jour où mon robot m’aimera (Albin Michel, 2015), 3-6-9-12, Utiliser les écrans et grandir (érès, 2017), L’Emprise insidieuse des machines parlantes, plus jamais seul (Les Liens qui Libèrent, 2020). RZ