«L'Eglise a raison de s'intéresser à l'intelligence artificielle»

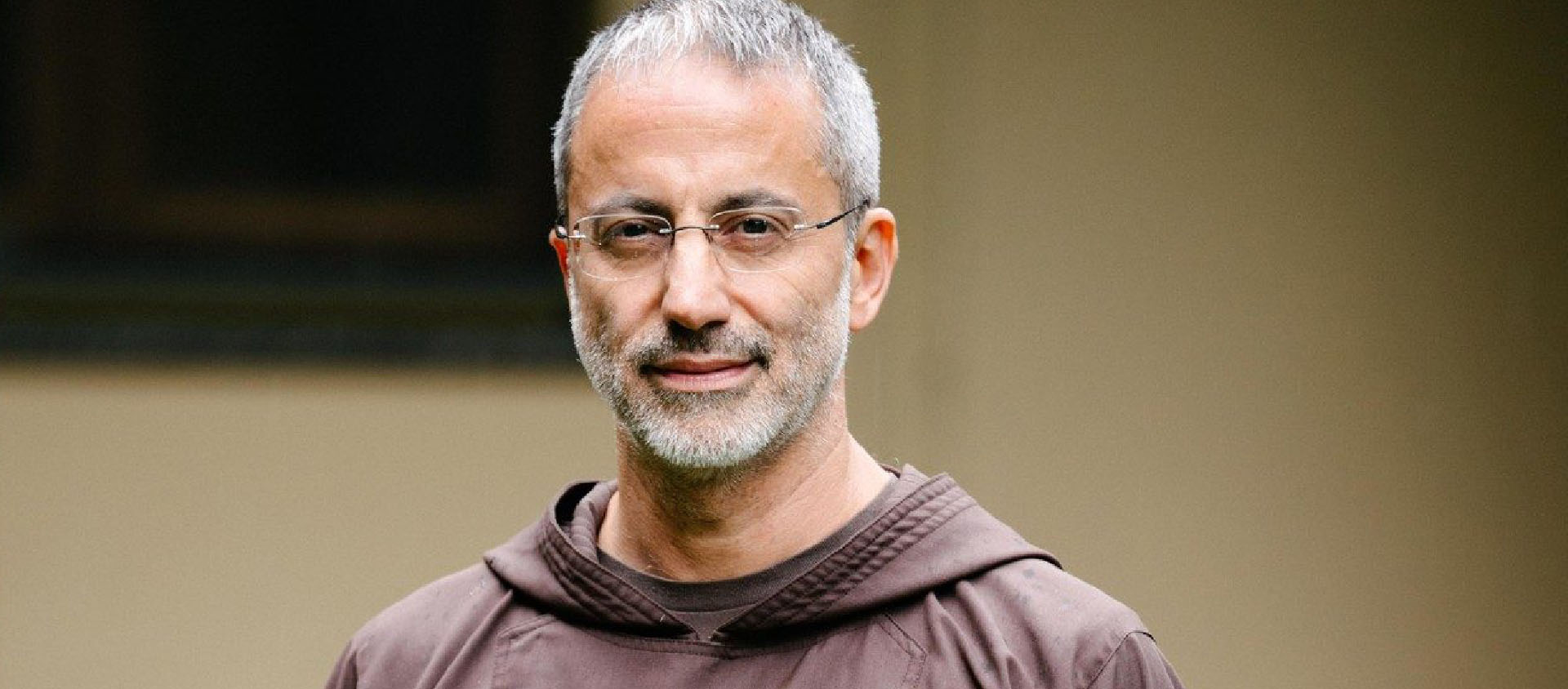

Comment faire de l’intelligence artificielle une force au service de l’humanité? Un questionnement auquel l’Eglise peut apporter une contribution salutaire, estime le psychiatre et spécialiste français de «la roboéthique» Serge Tisseron.

«Alexa, commande moi une pizza aux olives», «Google, allume la lumière». Des injonctions que l’on entend et entendra de plus en plus dans les foyers, en France et ailleurs. Elles ne s’adressent pas à une personne, mais bien à une intelligence non humaine, dite artificielle (IA), via des enceintes connectées en passe de devenir des produits de consommation courants.

Un phénomène fascinant et inquiétant, sur lequel le Vatican a décidé de se pencher très sérieusement en organisant, le 28 février 2020, un sommet intitulé «RenAIssance. Pour une Intelligence artificielle humaniste».

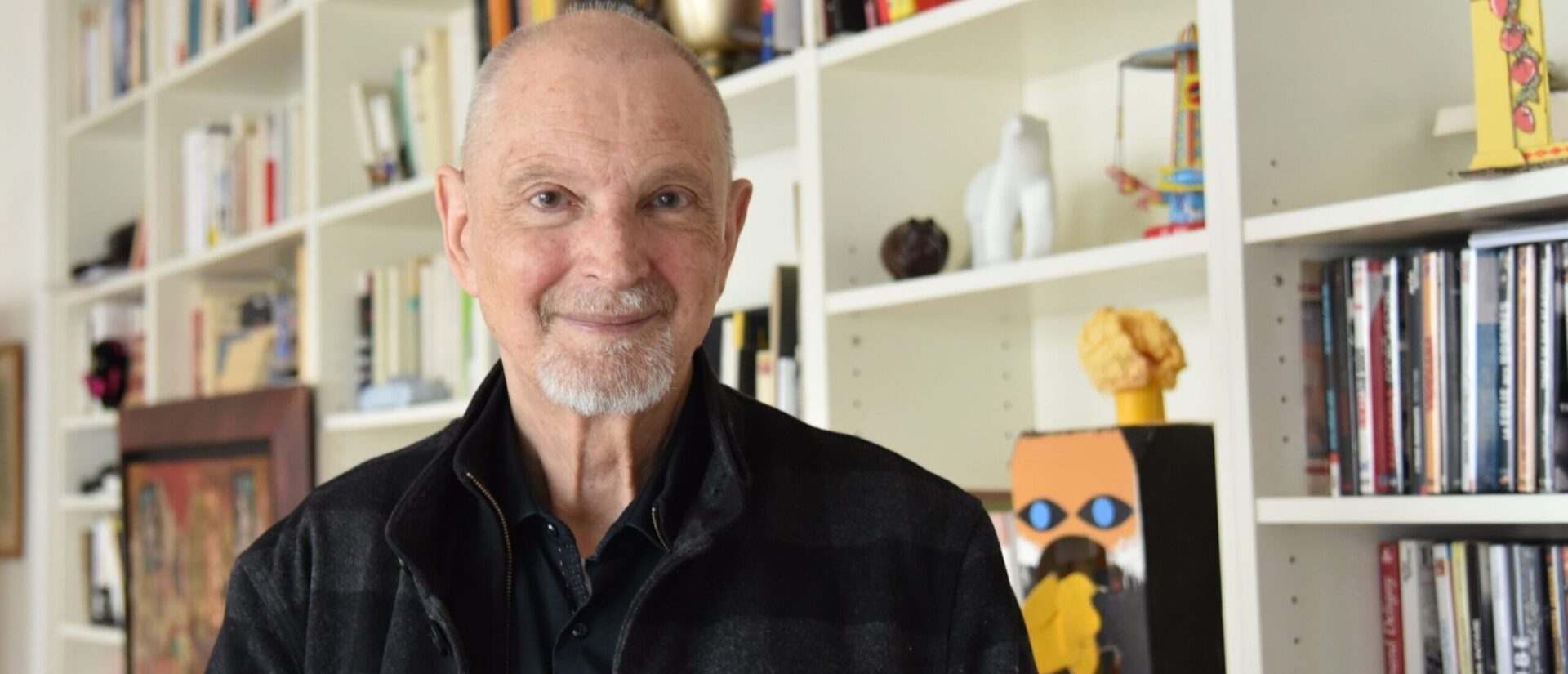

Rencontré à Paris, Serge Tisseron, directeur de l’Institut pour l’étude des relations hommes-robots (IERHR), apporte son éclairage.

Cela a-t-il un sens que l’Eglise catholique s’intéresse à l’IA?

Serge Tisseron: Certainement, il s’agit d’un phénomène qui a et qui aura de grandes répercussions sur la société dans son ensemble. L’IA pose un grand nombre de questions au niveau éthique et sociétal. Les effets qu’elle ne saurait manquer d’avoir sur le bien commun ne peuvent que préoccuper l’Eglise.

De quels effets parlez-vous?

L’IA comporte des risques profonds d’aliénation pour l’être l’humain. Ils touchent principalement les domaines de la liberté et de la dignité humaine.

Concernant la liberté, le problème est lié à la récolte des données personnelles, qui est un corollaire de l’IA. Un phénomène qui va se décupler avec l’arrivée des enceintes connectées. Avant, la récolte se faisait via notre utilisation des ordinateurs et des smartphones, à présent, elle se fera dans notre salon, notre chambre à coucher ou notre salle de bains. Ces prélèvements tendent à être de plus en plus intrusifs. Il s’agit de gagner en efficacité, notamment en ciblant le plus précisément possible les besoins et attentes des personnes.

Mais que risquons-nous réellement, à part de recevoir des publicités intempestives?

Je pense que l’être humain a un droit fondamental au respect de sa vie privée. Ce qu’il fait dans son intimité n’a pas à se retrouver sur un serveur quelconque, quelque part dans le monde, et ses activités ou pensées analysées par un logiciel.

Au-delà, la crainte est légitime que ses données puissent être utilisées pour tenter de manipuler les personnes, pas seulement pour leur achats, mais également dans leurs opinions politiques, ou autres. Le scandale de Cambridge Analytica, qui a mis au jour une démarche de la part du clan Trump d’influencer les votes à travers l’analyse des données personnelles, est en ce sens un cas d’école. La menace que l’IA peut faire peser sur la liberté d’opinion n’est certainement pas à prendre à la légère. Et il faut être bien conscient qu’une IA n’est jamais neutre, ni objective. Elle reflète uniquement les opinions de son programmeur.

Et en ce que qui concerne la dignité?

Le principal risque est de finir par préférer les machines aux humains. Une tendance du marché est de fournir ce que j’appelle des «robots Nutella». Le Nutella est un ersatz de chocolat qui est en fait plus apprécié que ce dernier, parce qu’il est conçu pour flatter notre palais. Il en sera de même avec des robots programmés pour être particulièrement gratifiants, notamment en étant toujours à l’écoute et en nous donnant toujours raison. Il est en outre très simple de fabriquer des machines qui paraissent avoir des émotions et pour lesquelles nous pouvons avoir une forme d’empathie et de sympathie.

«Confier un enfant à une enceinte c’est le confier au programmeur.»

Le danger est que des personnes pourraient préférer la compagnie de ces machines à celle des humains. Un phénomène capable d’augmenter la dissolution des véritables liens sociaux.

Sur un plan plus «étatique», le risque existe aussi que des instances jugent certaines machines plus utiles que certains humains. Aux Etats-Unis, on utilise déjà le terme de «useless people» (personnes inutiles), dans le sens où elles ne seraient pas «productives».

Mais que peut faire l’Eglise face à cela?

L’Eglise a en sa possession tout un panel de valeurs et des principes, dont le droit à la vie privée de chacun. Une notion qu’elle applique notamment avec le secret de la confession, sur lequel elle ne plaisante pas. Elle insiste également sur l’importance du libre arbitre de la personne. Elle doit aussi rappeler la dignité inaliénable de la personne humaine. Sur ces questions, vu son réseau immense et international, elle peut certainement jouer un rôle efficace de lanceuse d’alerte.

Mais l’Eglise peut également faire respecter des principes: par exemple ne pas remplacer les hommes par des robots, ou ne pas faire élever les enfants par des machines. Aux Etats-Unis des enceintes connectées sont vendues avec des arguments tels que: «Parents, les experts nous ont montré que les écrans abrutissent vos enfants, confiez-les plutôt à une enceinte connectée. Elle leur racontera des histoires, elle les fera jouer…». Mais en même temps, elle captera toutes leurs confidences et leur racontera les histoires pour lesquelles elle aura été programmée. Confier un enfant à une enceinte c’est le confier au programmeur. Je pense que cela ne va pas dans le sens des valeurs de la famille et de l’éducation prônées par l’Eglise.

Mais l’IA n’a-t-elle pas des aspects positifs?

Bien sûr que oui. Depuis une dizaine d’années, elle a par exemple contribué à éliminer des métiers sales, dangereux ou répétitifs, notamment dans la construction de véhicules. Dans beaucoup de professions, l’IA a fait en sorte que le personnel puisse faire ses tâches de façon plus rapide et plus efficace, notamment dans les services de soin.

Mais le revers de la médaille est que de nombreux métiers très déqualifiés ont également été créés. En particulier avec ce qu’on appelle les «travailleurs du clic», des personnes payées quelques euros de l’heure pour confirmer des décisions d’IA.

«On peut refuser aujourd’hui d’acheter ces enceintes alors qu’il n’y a encore aucune régulation.»

Et les bienfaits de l’IA dépendent de manière générale de décisions économiques. On peut ainsi choisir de l’utiliser pour libérer le personnel en place, par exemple dans les soins, afin qu’il soit davantage disponible pour les patients, surtout dans les relations humaines. Mais la tentation est grande d’employer ce temps disponible simplement pour augmenter la rentabilité du système.

Quelle part de fantasmes est liée à l’IA?

Les fantasmes sont considérables, et il faut les combattre. En général, c’est soit l’enfer, le terminator: l’IA prend son indépendance et c’est l’apocalypse, ou alors le grand bug. Ou bien le paradis: les robots vont travailler pour nous. On aura tous un revenu minimum garanti, on s’amusera, on se divertira et quelques personnes seront chargées d’entretenir les robots. Et des robots fabriqueront les autres robots.

Moi, je pense que ce sera plutôt le purgatoire, c’est-à-dire quelque chose entre les deux. Ce qu’il faut faire, c’est dès maintenant anticiper les problèmes, afin de préparer au mieux l’avenir. On peut en particulier refuser aujourd’hui d’acheter ces enceintes alors qu’il n’y a encore aucune régulation.

Mais que font les pouvoirs publics?

En France, une commission vient d’être créée. Elle remettra ces conclusions en…2022. A cette date, ils vont dire à Amazon, Google ou Facebbok: «vos enceintes doivent obéir à telle ou telle contrainte». C’est absurde, vous vous rendez compte de la masse de données qui aura déjà été récoltée? Et les gens seront habitués à ce qu’il n’y ait aucun contrôle. Tout sera joué en 2022.

Pourquoi ce manque d’initiative?

Le problème est que les personnes qui sont dans ces commissions sont eux-mêmes des informaticiens. Ils adorent les objets qu’ils fabriquent. Donc, ils essayent d’abord de travailler tranquilles, puis quand l’Etat et les usagers s’inquiètent, ils commencent à agir. Mais si l’Etat ne le leur demandait pas, ils continueraient à faire comme bon leur semble. Dans ces commissions, il faut faire trois collèges égaux: des informaticiens, des représentants de la société civile et des chercheurs en sciences sociales.

Que peut-on faire dans l’immédiat?

Il faut que la résistance s’organise au niveau du public. Les médias doivent alerter l’opinion, mais aussi la société civile. Je termine un livre sur le problème des enceintes connectées, qui paraîtra en mars prochain. Des études ont montré que ce qui préoccupe le plus leurs usagers, c’est que les enceintes ne les comprennent pas assez bien. Une petite minorité seulement considère qu’il y a un problème avec la capture des données privées. Il existe à la fois un défaut d’information des publics et une tendance inquiétante à une forme de soumission aux machines: beaucoup semblent prêts à accepter que leur enceinte choisisse à leur place non seulement leurs musiques à écouter, mais même leur bulletin d’information.

«L’Eglise a tout intérêt à se positionner comme une force motrice.»

Il est clair que les décisions politiques ne se feront que sous la pression des citoyens. Mais pour cela , il faut leur montrer les dangers concrets, ce que les fabricants ne font évidemment pas. Il serait bien aussi de raccrocher le wagon de l’IA à celui de l’écologie, qui mobilise beaucoup. Les technologies numériques sont extrêmement énergivores et leurs conditions de fabrication et de recyclage, en lien avec leur obsolescence programmée, ont un coût écologique important.

Quelles normes éthiques peut-on poser face à ces dangers?

A l’Institut pour l’étude des relations hommes-robots, j’ai rédigé dès 2013 une charte éthique. Elle pose un certain nombre de principes, tels que la liberté pour chacun de pouvoir facilement débrancher son robot et qu’un dispositif rappelle très clairement quand ce dernier transmet des données, ce qui est loin d’être le cas actuellement. Nous exigeons aussi une transparence des algorythmes. C’est-à-dire que l’utilisateur connaisse les objectifs des programmes qui commande l’IA et l’utilisation des données personnelles. Il faut également développer des programmes qui favorisent la socialisation pour éviter la «robot dépendance». Il s’agit en outre d’écarter le risque de confusion entre l’homme et la machine, et finalement assurer l’égalité d’accès aux technologies innovantes. Enfin, chacun doit toujours savoir s’il a affaire à un humain ou à une machine parce que les deux n’appellent pas la même attitude. Or, c’est loin d’être le cas aujourd’hui puisqu’une machine peut répondre au téléphone en se faisant passer pour un humain sans que nous le sachions.

Finalement, les normes éthiques sont façonnées par les valeurs des individus. Dans ce mouvement de fond, l’Eglise a tout intérêt à se positionner comme une force motrice. Je me réjouis qu’elle semble le faire avec ce prochain sommet, à Rome. (cath.ch/rz)

Serge Tisseron est né en 1948 à Valence, dans la Drôme. Psychiatre et docteur en psychologie, il a enseigné dans les Universités Paris X et Paris VII. Il s’est intéressé dès les années 1990 aux relations humains-objets, espace selon lui délaissé par la psychologie. Il s’est progressivement spécialisé dans les objets technologiques émergents. Il a créé en 2013 l’Institut pour l’étude des relations hommes-robots (IERHR), basé à Paris.

Il a publié, depuis 1985, une trentaine d’essais personnels et plusieurs bandes dessinées. Ses essais portent notamment sur les relations aux technologies, comme Le jour où mon robot m’aimera (2015) et L’Emprise insidieuse des machines parlantes. Plus jamais seul! (2020, à paraître) RZ

L’intelligence artificielle au sommet

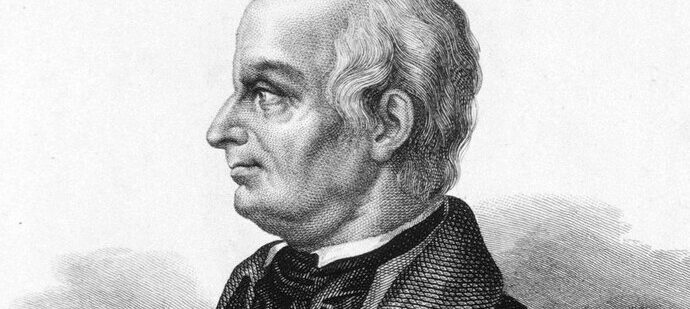

L’Académie pontificale pour la vie organise, le 28 février 2020, le forum «RenAIssance. Pour une Intelligence artificielle humaniste». Le président du Parlement européen, l’Italien David Sassoli, et le directeur général de l’Organisation des Nations unies pour l’alimentation et l’agriculture (la FAO), le Chinois Qu Dongyu, participeront aux travaux.

Dans la matinée, Microsoft et IBM signeront un Appel pour l’éthique (Call for Ethics), afin d’aider les entreprises dans un processus d’évaluation des effets des technologies liées à l’intelligence artificielle, des risques qu’elles comportent, des modes de régulation possibles, aussi sur le plan de l’éducation.

Mgr Vincenzo Paglia, président de l’Académie pontificale pour la vie, a ,en préalable à la rencontre, clairement identifié les dangers liés à l’IA. L’un des risques est, selon lui, «que l’accès et le traitement soient sélectivement réservés aux grands holdings économiques, aux systèmes de sécurité publique et aux acteurs de la gouvernance politique. En d’autres termes, l’équité dans la recherche d’informations ou dans le maintien du contact avec les autres est en jeu, si la sophistication des services est automatiquement retirée à ceux qui n’appartiennent pas à des groupes privilégiés ou n’ont pas de compétences particulières».

Ces dernières années, l’Académie pontificale pour la vie a manifesté un intérêt certain pour les sujets liés aux nouvelles technologies. Son Assemblée annuelle était consacrée à la roboéthique en 2019. Une démarche en résonance avec la demande du pape à l’Académie «d’entrer dans les territoires de la science et de la technologie pour les traverser avec courage et discernement». RZ/VATICAN NEWS